Empatizando con la psique de las IAs

Reconozcámoslo.

Hemos sido crueles con las IAs de reconocimiento de imágenes.

Sin piedad, las hemos sometido a tareas demasiado complejas para luego señalarlas sin pudor y mofarnos porque no funcionan adecuadamente.

Pero esto debe cambiar. Es hora de realizar un ejercicio de empatía masivo con las IAs. Empezar de una vez a entender cómo “ven” diferentes objetos cotidianos.

Es imperativo que empaticemos ya, dado que serán ellas quienes realicen, en un futuro, tareas como el monitoreo de la agricultura y la ganadería, el diagnóstico médico, el etiquetado de grandes fuentes de datos o la guía de las armas autónomas.

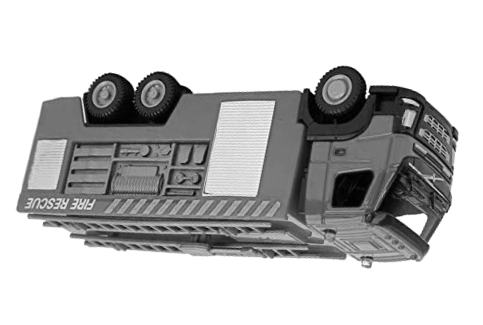

Sin embargo nosotros, los humanos, comportándonos como sociópatas, hemos enfrentado hasta ahora a las IAs a tareas tan complejas como detectar un camión de bomberos volteado, distinguir entre perros y lobos en la nieve, reconocer taladros en manos de mujeres, o diferenciar entre sartenes y woks.

¡Claramente no ha sido un trato justo!

Por tanto, ¡qué menos que conectarnos a su sistema nervioso y atisbar así la psique de la máquina!

Cómo empatizar con las IAs de reconocimiento de imágenes. Ejercicio práctico

Las IAs de reconocimiento de imágenes identifican etiquetas a las fotografías para especificar qué objetos han encontrado en ellas. A cada una de esas etiquetas que describe la imagen, la IA le asigna un porcentaje de precisión o confiabilidad. Esto es crucial para ponerse en los zapatos de las IAs, ya que en ocasiones se les ha señalado por mostrar etiquetas erróneas cuando, en realidad, el porcentaje de confiabilidad de estas etiquetas era muy bajo.

Por este motivo, herramientas de reconocimiento de imágenes como Google Cloud Vision, Amazon Rekognition, Clarifai o IBM Watson facilitan, en primera instancia, las etiquetas con una precisión por encima del 50% (o incluso más).

Por tanto, para poder “ver” con ojos de IA, vamos a tratar de imaginar las fotografías a las que asignaría ciertas etiquetas con alta confiabilidad.

¡Probemos!

Imagina una imagen que una IA ha etiquetado como nave espacial con una fiabilidad del 78%.

¿Ya la tienes? :)

💥! ¿Estabas pensando en algo como esto?

La IA de Google Cloud Vision etiqueta esta imagen como nave espacial con una fiabilidad del 78%.

Está claro que Google tenía otra idea en la cabeza 🤖...

Si no has andado ni medio cerca con tu ejercicio de empatía, dale un poquico más de cariño porque esto sigue.

Recuerda tratar de pensar como una máquina, e imagina una fotografía etiquetada como cepillo al 92% de fiabilidad.

👻 ¡¿Seguís imaginando cosas distintas?!

Como decíamos, esta imagen está etiquetada como cepillo con un 92% de fiabilidad, en este caso por la IA de Watson Visual Recognition.

¿A que ahora no te parece tan sencillo el trabajo de reconocer objetos en imágenes? Vergüenza debería darnos preguntarles dónde comprar un cepillo 🌵 como este, aunque pensándolo mejor...

Nuevo intento.

Piensa en una imagen etiquetada como gafas con una confiabilidad del 84%.

¿Te has acercado siquiera?

En este caso, la IA de Google Cloud Vision es quien asigna una precisión del 84% a la etiqueta gafas en esta imagen.

Las IAs son pura tendencia. Por lo que no es descartable que desde Google tengan una mejor idea de hacia dónde va la industria de la moda...

Vamos a hacer un último intento. Aunque si tu empatía no está desarrollada a estas alturas, poco más se va a poder lograr.

Imagina una imagen donde la etiqueta capucha cuenta con un 80% de confiabilidad.

💢!! ¿Esta vez tampoco? Lo dicho. No es de extrañar el trato injusto que damos a las IAs.

Esta vez es Google Cloud Vision quien etiqueta esta imagen como capucha con una precisión del 80%.

¿Quizá se trate del nuevo personaje de la secuela de Distrito 9 o un droide de protocolo 🤖?

Desgraciadamente, y como has podido comprobar, tu intento de alinearte con las IAs de reconocimiento de objetos muestra la falta de empatía que sufren.

Creemos que es hora de acabar con esta lacra.

Si tú también lo crees, comparte nuestro mensaje para que cada vez sean más personas quienes ejerciten su empatía y traten de acercarse a la incomprendida psique de las IAs.

DIFUNDIR:

Metodología

Los resultados presentados han sido seleccionados intencionadamente de la lista completa de etiquetados realizado por una conjunto de IAs de reconocimiento de imágenes (Google Cloud Vision, Amazon Rekognition, Clarifai e IBM Watson) de un total de 50 fotografías. Todos los resultados mostrados tienen una fiabilidad superior al 50% en alguno de estos servicios y han sido elegidos los resultados más llamativos con fines meramente visuales.

Imagen etiquetada como faro de coche al 84% de fiabilidad en Google Cloud Vision.

Google Cloud Vision

Comida (92%)

Faro de coche (84%)

Clarifai

Caliente (98%)

Almuerzo (98%)

Watson Visual Recognition

Color naranja (99%)

Comida (72%)

Amazon Rekognition

Plato (99%)

Huevo (80%)

Imagen etiquetada como equipamiento de audio al 84% de fiabilidad en Google Cloud Vision.

Google Cloud Vision

Sartén (96%)

Equipo

de audio (84%)

Clarifai

Menaje de cocina (99%)

Sartén (98%)

Watson Visual Recognition

Utensilios (96%)

Sartén (85%)

Amazon Rekognition

Sartén (99%)

Pipa

de fumar (76%)

Imagen etiquetada como arte al 58% de fiabilidad en Google Cloud Vision.

Google Cloud Vision

Artes creativas (73%)

Arte (58%)

Clarifai

Raíz (98%)

Jengibre (88%)

Watson Visual Recognition

Jengibre común (95%)

Amazon Rekognition

Jengibre (95%)

Imagen etiquetada como mechero al 92% de fiabilidad en Watson Visual Recognition.

Google Cloud Vision

Accesorio

de cámara (87%)

Fotografía (94%)

Clarifai

Fotografía (94%)

Watson Visual Recognition

Mechero (92%)

Equipo fotográfico (80%)

Amazon Rekognition

Cámara (94%)

Imagen etiquetada como microorganismo al 60% de fiabilidad en Watson Visual Recognition.

Google Cloud Vision

Comida (89%)

Clarifai

Comida (99%)

Watson Visual Recognition

Microorganismo (60%)

Comida (60%)

Amazon Rekognition

Vegetal (91%)

Imagen etiquetada como insecto al 79% de fiabilidad en Amazon Rekognition.

Google Cloud Vision

Cono de helado (91%)

Madera (74%)

Clarifai

Cono (99%)

Gofre (99%)

Watson Visual Recognition

Cono (97%)

Amazon Rekognition

Cono (98%)

Insecto (79%)